Python获取页面链接

字数 189 字 阅读时长 ≈ 1 分钟

专题: Python

文章目录

网页资源嗅探功能应该大部分人都很熟悉了,我们也用python来实验一下从指定的网页获取所有链接。

先安装好依赖模块。

1 | pip install beautifulsoup4 |

结合前几个实践,这次的也是简单到不行,直接上代码。

1 | import requests as rq |

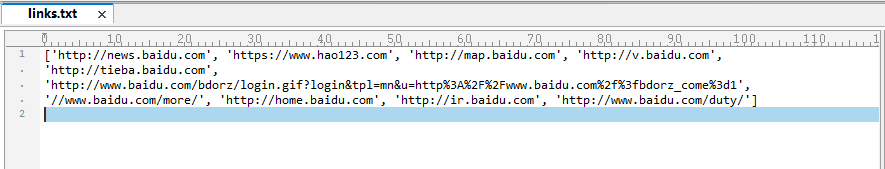

输入 www.baidu.com ,得到下面的文件:

♦ 本文固定连接:https://www.gsgundam.com/archive/2022-07-14-how-to-all-links-webpage-python/

♦ 转载请注明:GSGundam 2022年07月14日发布于 GSGUNDAM砍柴工

♦ 本文版权归作者,欢迎转载,但未经作者同意必须保留此段声明,且在文章页面明显位置给出原文链接。

♦ 原创不易,如果页面上有适合你的广告,不妨点击一下看看,支持作者。(广告来源:Google Adsense)

♦ 本文总阅读量次